Una nuova economia mondiale si manifesta sempre con l’avvento di nuove scoperte, fossero esse geografiche o tecnologiche. L’Intelligenza Artificiale è una nuova scoperta, la cui penetrazione cambierà il mondo.

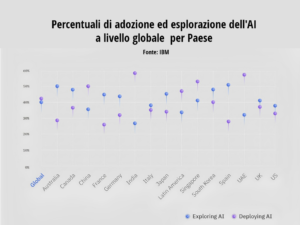

Ma cosa dicono i dati sull’uso dell’Intelligenza Artificiale? Secondo il Global AI Adoption Index 2023 di IBM, solo il 27% delle organizzazioni italiane con oltre 1.000 dipendenti usa l’AI nelle proprie attività, mentre il 48% delle aziende è in fase di valutazione.

Per quanto riguarda il mondo, il valore si attesta sul 42%. Guardando alla tavola delle principali applicazioni, la prima direttiva è l’automazione (IT, processi, utenti/dipendenti), la seconda è certamente la sicurezza.

Attenzione alla rivoluzione non televista né internettata: i mercati più propensi sono la Cina (85%), l’India (74%) e gli Emirati Arabi Uniti (72%), mentre arranca il Commonwealth (Regno Unito 40%, l’Australia 38% e il Canada 35%.

Le organizzazioni che usano soluzioni basate sull’Intelligenza Artificiale riescono a ridurre le attività manuali o ripetitive con strumenti di automazione (55%), soprattutto vista la carenza di competenze o manodopera che si prospetta strutturale.

Il principale spettro per tutti è la sicurezza: in Italia, è fattore critico per il 42% degli intervistati, seguito dalla consueta incapacità di padroneggiare i nuovi strumenti.

I tipi di attacco

Ovviamente l’AI estrae dai dati informazioni sensibili come minacce locali o generali, utilissime per azioni preventive o per l’impostazione delle policy. Da sempre la crittografia dei dati costituisce una semplice risposta ad alcuni tipi di cybercrime: oggi il settore è in forte espansione, anche per la scossa data dall’adozione di nuovi sistemi di cifratura complessivamente definiti “post-quantum”.

Parlando in generale, molti attacchi sono diretti a persone (comportamentale, phishing, deepfake e così via), a semplici sistemi di sicurezza (come i Captcha o similari). Ad alto livello troviamo gli attacchi da Stati canaglia.

L’Intelligenza Artificiale, il Machine Learning (ML) e l’automazione sono usati negli attacchi alla sicurezza informatica. Le varie tecniche sono utili sia ai defender, sia agli attacker; questi ultimi sono avvantaggiati perché non devono rispettare le leggi.

Viene evidenziato il passaggio da attacchi individuali a operazioni di gruppi criminali organizzati e come l’AI e il ML siano impiegati sia in attacchi che in difese.

Le AI usate dai cybercriminali

Due diverse azioni, l’automazione e l’AI generativa, che molto spesso vengono confuse tra loro.

La scrittura automatica di codice, sia esso un virus o la clonazione di un sito web ufficiale, ha reso gli attacchi più efficaci e veloci. Grazie al Machine Learning, gli strumenti di scansione automatica (che esistono da molto tempo) hanno raggiunto livelli di prestazioni senza precedenti.

In particolare è in forte aumento l’impiego di sistemi di Intelligenza Artificiale generativa, tra cui ChatGPT, per avviare attacchi informatici e creare contenuti dannosi. I cybercriminali si avvalgono di strumenti avanzati basati sull’AI, che diventa così una minaccia. WormGPT, FraudGPT, DarkBERT, DarkBART e ChaosGPT sono alcuni tra gli strumenti di AI più usati dagli hacker, come spiega Alarming rise in cyberattacks, SMBs and MSPs in the crosshairs, il report Acronis sulle minacce digitali 2023 (SMB sono gli Small and Medium Business, le PMI).

La stessa Intelligenza Artificiale che crea email personalizzate come variazione della stessa lettera di base crea anche malware polimorfici, che partono da una base ma adottano virus leggermente mutati difficili da identificare dal software tradizionale.

Come per il marketing, anche i cyberattacchi sono oggi automatizzati con grande qualità. D’altronde i criminali avevano già sviluppato strumenti automatizzati venduti as-a-service, aperti e facili da usare. L’AI e l’AI generativa aiutano sia l’azienda, sia il criminale: in quest’ultimo caso possono contribuire allo sviluppo delle componenti di un incidente cyber, dal DDoS al phishing al ransomware fino alla nuova tipologia dei deep fake e dei tentativi di estorsione basati su rapimenti virtuali (voice cloning).

Cosa fanno gli Stati canaglia

Spionaggio e terrorismo esistono, com’è noto, anche a livello di strategie di interi Stati. La migliore risposta a questo tipo di attacco è data dalla cooperazione internazionale, attiva a livello di aziende ma molto meno tra Stato e Stato.

L’AI viene usata per eseguire ricognizioni automatizzate su potenziali bersagli. Gli attacchi sono progettati per interrompere le operazioni, seminare il caos, causare danni economici (diretti o indiretti) oltre che per il classico furto d’informazioni, anche per individuare potenziali bersagli non facilmente raggiungibili. Certamente nell’era digitale la vasta quantità di dati disponibili può essere sfruttata per fornire approfondimenti e analisi. In particolare le ricerche OSINT, acronimo di Open Source Intelligence, si riferiscono al processo di raccolta e analisi di informazioni che provengono da fonti pubblicamente accessibili. Queste fonti includono siti web, database pubblici, pubblicazioni, report di media, dati di social media e qualsiasi altra informazione disponibile pubblicamente. L’OSINT è ampiamente utilizzata in vari settori, come la sicurezza nazionale, l’intelligence, la ricerca giornalistica e il settore privato, per raccogliere informazioni rilevanti e utili senza ricorrere a mezzi occulti o riservati.

Il caso del poisoning

Nell’Intelligenza Artificiale i sistemi vengono allenati a riconoscere dati utili e a identificare quelli non corretti. Il sistema funziona bene solo se c’è disponibilità di un’enorme mole di dati. In quest’ambito l’attaccante può modificare la base di dati (inserendone di incorretti o tendenziosi) oppure provare a duplicare l’intera base di dati.

Si parla di “poisoning” (avvelenamento) dei dati quando l’attaccante cerca di manipolare i set di dati di addestramento delll’Intelligenza Artificiale oppure di introdurre dati di input con l’obiettivo di indurre errori nel sistema. Si parla invece di “inference” quando gli attaccanti decodificano i sistemi AI per accedere a dati sensibili o replicare il sistema AI.

Un’area di ricerca avanzata è il Machine Learning nell’analisi di sistemi crittografici, per identificare e sfruttare vulnerabilità analizzando modelli e inconsistenze. Questo approccio può rivelare punti deboli nei sistemi crittografici, permettendo agli esperti di migliorare la sicurezza e la robustezza di tali sistemi.

Azioni concrete: le AI per la sicurezza

Impostando standard di riferimento e analizzando comportamenti usuali, gli algoritmi di Intelligenza Artificiale sono capaci di rilevare anomalie e segnalare potenziali pericoli, come intrusioni interne, malware o tentativi di accesso non autorizzati. L’elemento cruciale in questi contesti è il tempo: l’azione dell’AI è solitamente più rapida da attuare e più letterale nell’esecuzione delle policy.

Inoltre l’AI può autonomamente isolare IP sospetti, mettere in quarantena dispositivi compromessi o attivare protocolli di reazione agli incidenti basandosi su regolamenti e linee guida prestabiliti.

Inoltre un’AI addestrata può fungere da interfaccia tra un esperto di sicurezza competente sulle minacce ma non addentro allo specifico mix hardware/software dell’organizzazione.

La valutazione: efficienza e integrazione

Secondo un’analisi, i team di sicurezza aziendali possono gestire fino a 70 strumenti di sicurezza. Tra le necessità più importanti ci sono la valutazione dell’aumento di efficienza e l’integrazione dell’AI nello stack di sicurezza esistente.

Il numero di strumenti nello stack è molto elevato, superiore a 70 (Panaseer 2022).

Più critico appare il problema di scetticismo nell’AI, con “sano scetticismo nei confronti dell’AI tra i leader della sicurezza, con oltre il 28% che ha poca o nessuna fiducia nell’Intelligenza Artificiale per prendere decisioni critiche in materia di sicurezza” (Panaseer 2024).

Per quanto riguarda l’integrazione di nuovi strumenti nello stack, “i vendor dovrebbero essere tenuti a garantire che ogni aspetto del processo di implementazione sia coperto – dice Massimiliano Galvagna, country manager per l’Italia di Vectra AI – per il rilevamento e la risposta alle minacce, in particolare, la soluzione di Intelligenza Artificiale deve fornire informazioni all’infrastruttura esistente e facilitare la risposta del team alle minacce più urgenti”.

I rimedi: audit, formazione e assicurazione

La formazione e la sensibilizzazione dei dipendenti sulla sicurezza informatica, integrata con l’Intelligenza Artificiale, possono aumentare significativamente la difesa in generale e in particolare contro gli attacchi di social engineering. In questo caso la formazione non è rivolta al personale specializzato, ma a tutto il personale generale -e potendo anche a quello dell’intera filiera- che deve tenere comportamenti sicuri per l’azienda.

L’AI può personalizzare i programmi formativi, rendendoli più efficaci nel riconoscimento delle minacce recenti e nell’uso responsabile delle tecnologie.

Parallelamente, l’AI può essere usata per potenziare gli audit e le valutazioni di sicurezza regolari, fornendo analisi più approfondite e identificazione tempestiva delle vulnerabilità, specialmente in aree influenzate da tecnologie emergenti, migliorando così la resilienza dell’organizzazione.

Anche in questo campo, comunque, allo skill shortage si sta rispondendo con formazione, collaborazione e automazione.

La formazione, o meglio l’aggiornamento, vale anche per le competenze di quadro e strategiche dei dirigenti. Una questione vecchia come l’informatica è che la sicurezza sia una responsabilità esclusiva del reparto IT. Sinceramente non è più possibile andare avanti con idee come questa: dai dirigenti ai nuovi assunti, ciascuna persona all’interno dell’organizzazione svolge un ruolo fondamentale nella salvaguardia. Questa osservazione si applica anche al singolo utente di device individuale.

“Un dipendente istruito è l’alleato più forte nella continua battaglia contro la criminalità informatica – scrive Conor O’Doherty di MetaCompliance -; la formazione sulla sicurezza va messa al centro delle considerazioni sul budget”.

I dipendenti non devono subire la formazione, bensì seguirla attivamente. Un metodo è l’adattamento della formazione ai singoli ruoli e rischi di una grande organizzazione. Inoltre aggiornamenti regolari sulle minacce emergenti, moduli di apprendimento (anche gamificati) e incentivi per comportamenti positivi favoriscono un approccio proattivo alla sicurezza.

L’adozione di nuove tecnologie come l’AI e l’impatto della pandemia da COVID-19 hanno reso necessarie clausole aggiuntive nelle assicurazioni per la sicurezza ICT. Queste clausole dovrebbero affrontare i rischi e i relativi benefici. Ad esempio, l’adozione dell’AI nel settore assicurativo comporta vantaggi e costi, e le compagnie di assicurazione devono considerare i potenziali rischi associati all’implementazione dell’AI, come la sicurezza dei dati e il rischio di conformità a numerose legislazioni in tutto il mondo.

Le stesse compagnie di assicurazione si distingueranno per la qualità degli strumenti AI che renderanno disponibili ai propri dipendenti e ai propri clienti.

Si può fare un’analogia con quanto accaduto con il COVID-19. La pandemia ha accelerato l’integrazione dell’IoT e dell’AI in vari settori, tra cui sanità, case intelligenti, edifici intelligenti, città intelligenti, trasporti e IoT industriale.

Le nuove clausole per le assicurazioni per la sicurezza ICT dovrebbero quindi includere disposizioni per affrontare i rischi e i benefici dell’adozione dell’Intelligenza Artificiale, l’integrazione del cloud e l’implementazione dell’IoT nel contesto del settore assicurativo. Si potrebbe includere la copertura per la sicurezza dei dati, il rischio di conformità, il rischio normativo e l’impatto potenziale delle procedure di approvazione e dei cambiamenti normativi sull’adozione dell’IoT. Le compagnie di assicurazione dovrebbero inoltre considerare la necessità di clausole legate al “rischio umano”, come la mancanza di conoscenze, competenze e capacità interne, già comuni nell’adozione del cloud e sempre più amplificate dalla mancanza di personale qualificato e di competenze anche tra i cosiddetti tecnici.