Il cloud ha promesso di risolvere ogni problema di elaborazione dati. Ma c’è un limite fisico invalicabile: la velocità della luce. Quando i dati devono viaggiare da una fabbrica in Lombardia verso un data center in Irlanda e tornare indietro, anche nella migliore delle connessioni si perdono decine di millisecondi. Per un report aziendale non fa differenza. Per un robot che deve decidere se fermare una linea produttiva o per un’auto autonoma che deve frenare, può essere la differenza tra successo e disastro.

L’edge computing sposta la potenza di calcolo dove servono le decisioni: ai margini della rete, vicino ai sensori, alle macchine, ai dispositivi che generano i dati. Non è una contrapposizione al cloud, ma un’evoluzione necessaria del paradigma dell’elaborazione distribuita. Il principio è semplice nella teoria, complesso nella pratica: elabora localmente ciò che è urgente e critico, invia al cloud centrale solo ciò che serve per analisi più approfondite, correlazioni tra dataset diversi o archiviazione di lungo periodo.

Trasformazione già in atto

Il mercato globale dell’edge computing raggiungerà i 424 miliardi di dollari entro il 2030, crescendo con un tasso annuo del 13,2% a partire dal 2025 (Mordor Intelligence). Il dato più significativo, però, arriva dalle aziende: nel 2023, oltre metà delle nuove implementazioni IT ha incluso componenti edge come elemento strutturale, non accessorio. Non è più una tecnologia di nicchia per casi d’uso estremi, è diventata mainstream per qualsiasi organizzazione che lavori con dati in tempo reale.

La ragione economica è altrettanto forte di quella tecnica. Con 35 miliardi di dispositivi IoT previsti entro il 2025 (Mordor Intelligence), la “gravità dei dati” diventa letteralmente ingestibile dal punto di vista dei costi. Se ogni sensore industriale dovesse inviare ogni singola rilevazione al cloud per l’elaborazione, i costi di trasmissione e archiviazione sarebbero insostenibili. Stiamo parlando di terabyte generati ogni giorno da singole linee produttive, da flotte di veicoli, da reti di sensori ambientali.

L’edge funge da filtro intelligente prima ancora che da processore veloce: elabora i dati grezzi, scarta il rumore e le ridondanze, aggrega le informazioni rilevanti, trasmette al cloud solo l’essenziale. Il risultato è un’ottimizzazione drastica delle spese IT. Le aziende che hanno implementato soluzioni edge-AI registrano un aumento del 23% nell’efficienza operativa rispetto a quelle che usano solo cloud centralizzato (Spindox Research).

Il caso dell’automotive è emblematico

A 120 km/h, un veicolo percorre circa 33 metri al secondo. Un ritardo di 100 millisecondi nell’elaborazione se frenare o no può essere fatale. Non si può aspettare che i dati del sensore LiDAR facciano il giro del cloud, vengano elaborati da un’AI remota e tornino indietro. Serve elaborazione locale, immediata e affidabile. Per questo i veicoli stanno diventando data center su ruote, capaci di elaborare gigabyte di dati al secondo e prendere decisioni critiche in tempo reale.

Nell’industria 4.0, l’89% dei produttori sta spostando l’analisi AI su gateway locali per il controllo qualità in tempo reale (Mordor Intelligence). Robot e macchinari analizzano n parametri di usura in tempo reale e decidono in microsecondi se continuare la produzione o fermarsi per manutenzione preventiva.

L’edge computing nella sanità sta abilitando il monitoraggio continuo dei pazienti: dispositivi indossabili e sensori ospedalieri generano flussi costanti di dati biometrici. Elaborare tutto nel cloud comporterebbe non solo problemi di latenza, ma anche rischi enormi per la privacy e la conformità normativa. Attraverso una piattaforma edge i dati sensibili sono elaborati in locale e le notifiche inviate al personale solo per anomalie significative; garantendo al contempo che i dati sensibili non escano mai dal perimetro ospedaliero se non in forma aggregata e anonimizzata. Un altro vantaggio è la resilienza. I dispositivi edge continuano a funzionare anche se la connessione al data center centrale si interrompe. Per settori come oil & gas, dove gli impianti sono spesso in aree remote con connettività intermittente, questa autonomia operativa non è un lusso, è una necessità vitale.

Dalla tecnologia alla gestione

Distribuire calcolo significa distribuire complessità: non più un data center da monitorare, ma migliaia di nodi da aggiornare, proteggere, orchestrare. Per questo i reparti IT stanno adottando tecnologie cloud-native come Kubernetes anche per l’edge, trasferendo al perimetro le stesse logiche di containerizzazione, orchestrazione e sicurezza che hanno imparato a gestire nei data center centralizzati. L’edge non può essere un’infrastruttura gestita manualmente, sito per sito. Deve essere trattato come un’estensione del cloud, con automazione spinta e intelligence distribuita.

Le piattaforme di orchestrazione edge, alcune potenziate da AI, permettono la gestione completa del ciclo di vita dell’implementazione: deployment del software, aggiornamenti over-the-air, monitoraggio end-to-end, gestione della sicurezza, tutto da un’unica console centralizzata. Senza questi strumenti, scalare l’edge oltre qualche decina di siti diventerebbe impraticabile.

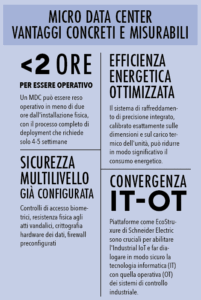

Micro data center, il cuore nascosto dell’edge

Dimenticatevi le sale server con file di rack, sistemi di raffreddamento rumorosi, personale specializzato che monitora temperature e consumi. I Micro data center (MDC) sono unità compatte, autonome, dalle dimensioni di un grande frigorifero industriale, che racchiudono in un’unica soluzione integrata tutto ciò che serve: capacità di calcolo, storage, apparati di rete, sistema di raffreddamento di precisione, sicurezza fisica e logica. Sono progettati per essere installati esattamente dove servono.

Gli MDC eliminano la necessità di avere personale IT qualificato costantemente in loco. Sono sigillati, monitorabili e gestibili da remoto, progettati per operare in ambienti non condizionati con temperature e umidità variabili. Per un’azienda con decine o centinaia di siti distribuiti sul territorio, significa portare potenza di calcolo di livello enterprise ovunque serva, senza dover costruire infrastrutture dedicate.